6 Minuten

Neue Forschungsergebnisse der University of Pennsylvania deuten darauf hin, dass künstliche Intelligenz aus Fotos Persönlichkeitsmerkmale extrahieren und diese Informationen nutzen kann, um berufliche Ergebnisse vorherzusagen. Diese Erkenntnis wirft weitreichende Fragen zu automatisierten Einstellungsprozessen, Kreditentscheidungen und der Ethik von Gesichtsanalyse als Indikator für Beschäftigungsfähigkeit auf. Vor dem Hintergrund von Datenschutz, algorithmischer Fairness und möglichen Verzerrungen ist die Studie ein Anlass, bestehende Praktiken zu hinterfragen und mögliche Schutzmaßnahmen zu entwickeln.

How the study worked — faces, algorithms, and the Big Five

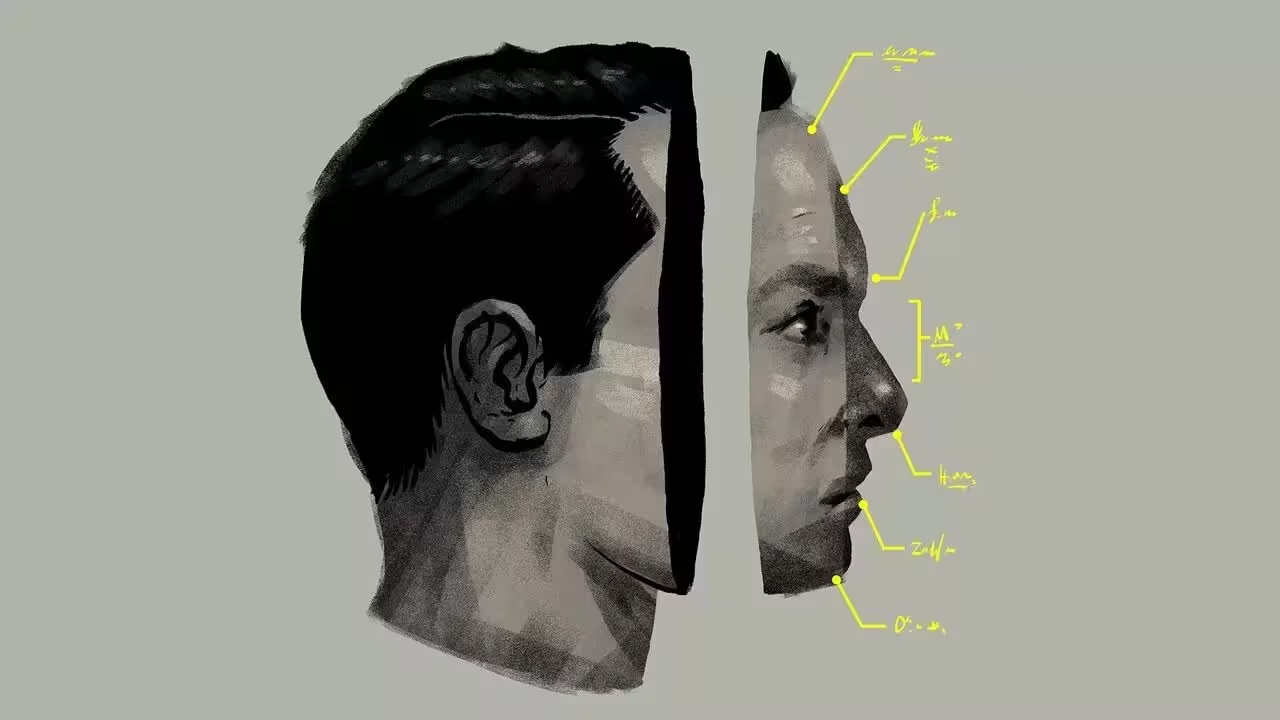

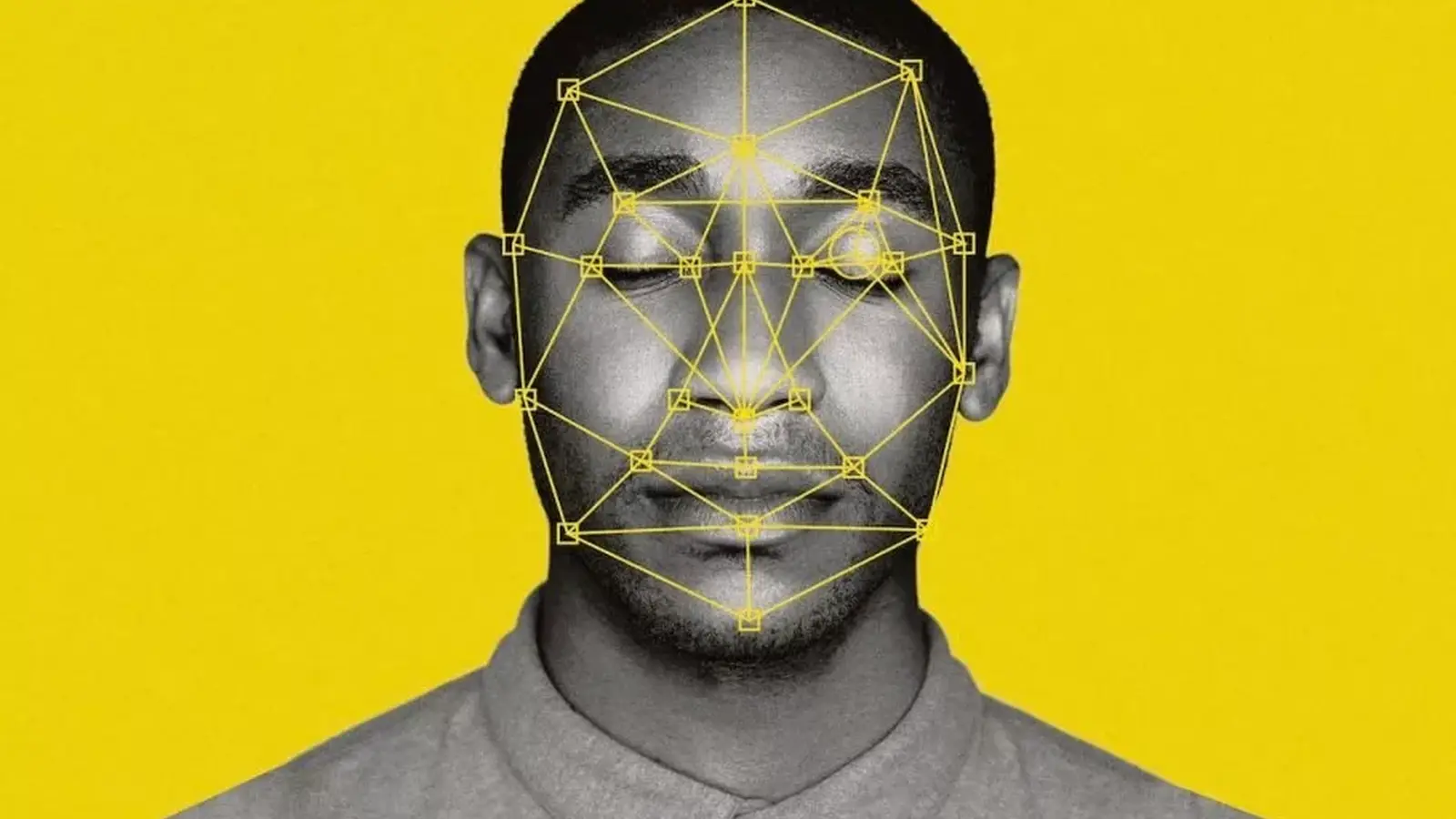

Das Forschungsteam trainierte ein Machine‑Learning‑Modell auf Grundlage vorangegangener Studien, die Zusammenhänge zwischen Gesichtsmerkmalen und Persönlichkeitsprofilen untersuchten. Für die Analyse sammelten die Forschenden LinkedIn‑Profilbilder von etwa 96.000 MBA‑Absolventinnen und -Absolventen und setzten ein KI‑System ein, um Schätzwerte für die fünf grundlegenden Persönlichkeitsdimensionen zu berechnen: Offenheit, Gewissenhaftigkeit, Extraversion, Verträglichkeit und Neurotizismus (die sogenannten „Big Five“). Die Auswahl dieser Merkmale entspricht etablierten psychometrischen Modellen, die in Personalpsychologie und Arbeitsmarktforschung häufig verwendet werden, und erlaubt Vergleiche mit anderen Studien.

From pixels to personality scores

Die KI analysierte millimetergenau Pixelmuster, Gesichtsproportionen, Ausdrucksmerkmale und subtile Gestaltungsinformationen, um numerische Schätzwertung für die einzelnen Traits zu erzeugen. Anschließend verglichen die Forschenden diese inferierten Persönlichkeitswerte mit realen Arbeitsmarktdaten wie Gehalt, beruflicher Laufbahnentwicklung und anderen Indikatoren beruflichen Erfolgs. Statistische Tests zeigten mehrere signifikante Korrelationen: aus dem Gesicht abgeleitete Extraversion korrelierte am stärksten positiv mit höheren Einkommen in dieser Stichprobe, während eine inferierte Offenheit mit niedrigeren Einkommen assoziiert war. Die Studie berichtet ferner über Kontrollanalysen, die Faktoren wie Alter, Geschlecht, Branche und geografische Verteilung berücksichtigen, um mögliche Confounder zu reduzieren. Wichtig ist, dass Korrelation nicht gleich Kausalität ist: die Modelle identifizieren Muster und Zusammenhänge in den Daten, aber sie liefern keine direkten kausalen Erklärungen, warum bestimmte Gesichtsmerkmale mit bestimmten Berufsverläufen verknüpft erscheinen.

Why this matters: hiring, lending and algorithmic fairness

Stellen Sie sich automatisierte Screening‑Systeme vor, die eine zusätzliche Schicht der Gesichtsanalyse über Lebensläufe und Interviews legen. Medienberichte, etwa in The Economist, und das in SSRN veröffentlichte Paper legen nahe, dass finanzielle Anreize Unternehmen dazu verleiten könnten, solche Tools zur Feinabstimmung von Einstellungs-, Miet‑ oder Kreditentscheidungen zu nutzen. Für viele Beobachter ist diese Perspektive alarmierend: Bewerberinnen und Bewerber aufgrund eines Algorithmus auszuschließen, der „unerwünschte“ Persönlichkeitsmerkmale aus ihrem Gesicht prognostiziert, birgt das Risiko, bestehende Vorurteile zu verfestigen und Antidiskriminierungsnormen zu verletzen. Algorithmische Entscheidungen wirken häufig intransparent; wenn Unternehmen automatisierte Inferenzmodelle ohne ausreichende Validierung verwenden, können Verzerrungen des Trainingsdatensatzes (z. B. Überrepräsentation bestimmter Gruppen auf LinkedIn) systematisch benachteiligte Gruppen verstärken.

Die Autorinnen und Autoren der Studie betonen entsprechend Vorsicht im Umgang mit den Ergebnissen. Sie beschreiben die Modellausgaben als eine zusätzliche Informationsquelle — nicht als endgültigen Beweis für Charakterzüge oder zukünftige Leistungen. Die Forschung zur Gesichtsanalyse von Verhaltensmerkmalen steht noch am Anfang, und die Genauigkeit der Modelle variiert erheblich zwischen verschiedenen Populationen, Kulturkreisen und Anwendungskontexten. Fehlklassifikationen können soziale Ungleichheiten verstärken, wenn Arbeitgeber, Banken oder Vermieter algorithmische Rückschlüsse als maßgebliche Entscheidungsgrundlage betrachten. Darüber hinaus ist zu beachten, dass Profile in sozialen Medien und berufliche Fotos oft kuratiert sind; sie spiegeln nicht notwendigerweise stabile Persönlichkeitseigenschaften, sondern situative Präsentationsstrategien, kulturelle Normen oder technische Eigenschaften der Bilder (z. B. Beleuchtung, Kamerawinkel) wider.

Possible benefits, real risks and unintended consequences

Befürworter argumentieren, dass Gesichtsanalyse in sehr begrenzten Szenarien nützlich sein könnte, insbesondere wenn kaum andere Daten zur Verfügung stehen — etwa bei Kreditzusagen für Menschen mit eingeschränkter finanzieller Vorgeschichte oder in Märkten mit schwacher Dokumentation. In solchen Fällen könnten algorithmische Signale ergänzende Hinweise liefern, die ansonsten fehlen würden. Allerdings warnt das Paper vor langfristigen Verhaltensfolgen: Eine breitflächige Anwendung von Gesichtsanalyse‑Tools könnte Anreize schaffen, das eigene Erscheinungsbild digital zu manipulieren oder sogar kosmetische Eingriffe vorzunehmen, um automatisierte Systeme zu „täuschen“. Solche Anpassungen würden die Validität von Modellen weiter untergraben und neue soziale Ungerechtigkeiten schaffen.

Neben ethischen Bedenken bestehen auch erhebliche rechtliche und technische Herausforderungen. Tools zur Gesichtserkennung und Persönlichkeitsinferenz berühren Datenschutzrecht (beispielsweise die DSGVO in der EU), Antidiskriminierungsgesetze (z. B. Gleichbehandlungsrechte, arbeitsrechtliche Vorschriften) sowie aufkommende Regulierungen für automatisierte Entscheidungssysteme. Ohne robuste Transparenz, unabhängige Audits, technische Maßnahmen zur Bias‑Minderung und klare Verantwortlichkeitsregelungen kann eine Implementierung in großem Maßstab Schaden anrichten. Technisch sind Maßnahmen wie faire Datenaufbereitung, Einsatz von Fairness‑Metriken (z. B. disparate impact, equalized odds), adversarielle Robustheitstests, Explainable AI‑Methoden und menschliche Entscheidungsinstanzen (Human‑in‑the‑Loop) notwendig, um Risiken wenigstens zu reduzieren — sie sind jedoch kein Allheilmittel.

What to watch next

Wissenschaftlerinnen und Wissenschaftler führen derzeit weitere Tests durch, um zu prüfen, ob aus dem Gesicht inferierte Signale in verschiedenen Arbeitsmärkten, Branchen und demografischen Gruppen prädiktiven Wert besitzen. Entscheidend sind unabhängige Replikationen, offene Datensätze und transparente Methodik, damit die Befunde nachvollziehbar und überprüfbar werden. Politik, Forschung und Zivilgesellschaft müssen eine öffentliche Debatte darüber führen, ob und unter welchen Bedingungen eine Nutzung von KI‑basierten Persönlichkeitsinferenzsystemen legitim ist — etwa durch klar definierte Zweckbindung, Einwilligungsregeln, Löschmechanismen und Aufsichts‑ sowie Sanktionsinstrumente.

Bislang erinnert die Studie vor allem daran, dass Maschinenlernverfahren Muster finden können, die Menschen leicht übersehen — doch Muster sind keine Beweise. Entscheidungsträger in Politik, Wirtschaft und Technik sollten den potenziellen Nutzen gegen die Risiken für Fairness, Privatsphäre und individuelle Autonomie abwägen. Praktische Empfehlungen umfassen die Pflicht zur Offenlegung der verwendeten Algorithmen, unabhängige Audits auf Bias und Genauigkeit, Benchmarking auf diversen Bevölkerungsgruppen sowie die Entwicklung von Alternativen, die menschliches Urteilsvermögen mit erklärbaren, validierten Modellvorhersagen kombinieren. Nur so lassen sich Innovationen auf dem Gebiet der künstlichen Intelligenz verantwortungsbewusst gestalten und die Chancen für gerechte Anwendungen wie faire Bewerberauswahl, transparente Kreditvergabe und den Schutz individueller Rechte erhöhen.

Quelle: smarti

Kommentar hinterlassen