8 Minuten

Neue Forschungsergebnisse deuten darauf hin, dass es beim Folgen einer Unterhaltung in einem lauten Raum nicht nur auf die Ohren ankommt, sondern auch darauf, wie das Gehirn Schall verarbeitet. Eine aktuelle Studie unter Leitung der University of Washington stellt einen Zusammenhang zwischen geringerer kognitiver Leistungsfähigkeit und stärkerer Schwierigkeit beim Verstehen von Sprache im Hintergrundlärm fest — selbst wenn herkömmliche Hörtests normale Ergebnisse zeigen.

Stimmen entwirren: das Cocktailparty-Problem und die Kognition

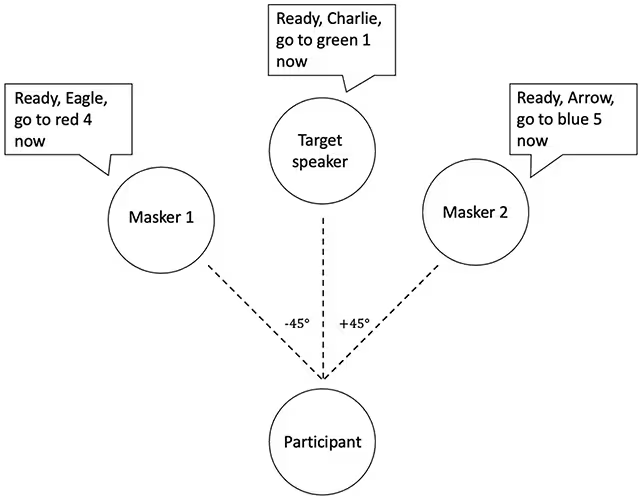

Die Forschenden prüften Freiwillige mit einer klassischen Höraufgabe, die oft als "Cocktailparty-Problem" bezeichnet wird: die Fähigkeit, sich auf eine einzelne Stimme zu konzentrieren, während mehrere andere gleichzeitig sprechen. Anstatt reale Gespräche einzusetzen, nutzte das Team computergenerierte Sprachströme, um die Überlappung der Stimmen präzise zu kontrollieren. Die Teilnehmenden sollten Instruktionen in den Zielgesprächen verfolgen, während andere Stimmen simultan abgespielt wurden.

Die Studiengruppe umfasste 12 Menschen mit Autismus und 10 mit fetalem Alkoholsyndrom — beides Bedingungen, die zuvor mit Schwierigkeiten beim Hören in lauten Umgebungen in Verbindung gebracht wurden und ein breites Spektrum an IQ-Werten abdeckten. Eine Kontrollgruppe aus 27 neurotypischen Teilnehmern, alters- und geschlechtsangepasst, absolvierte dieselben Aufgaben. Wichtig ist: Alle Teilnehmenden zeigten klinisch normales peripheres Hören, das heißt ihre Ohren erfassten Töne innerhalb erwarteter Bereiche bei Standardtests (Audiogramm).

Diese Versuchsordnung erlaubt es, zentrale Verarbeitungsprozesse zu isolieren: Wenn Menschen mit normalem Hörvermögen dennoch Probleme haben, Sprache im Rauschen zu erkennen, liegt die Ursache vermutlich in der zentralen auditorischen Verarbeitung, in Aufmerksamkeitsmechanismen oder im Arbeitsgedächtnis — und nicht primär in einem Verlust der peripheren Hörfähigkeit.

Was die Ergebnisse über Sprachwahrnehmung und IQ verraten

Innerhalb aller drei Gruppen korrelierte geringere kognitive Leistungsfähigkeit mit einer schlechteren Performance bei der Sprach-im-Rauschen-Aufgabe. Wie die auditiv-neurowissenschaftliche Forscherin Bonnie Lau von der University of Washington anmerkt: "Die Beziehung zwischen kognitiver Leistungsfähigkeit und Sprachwahrnehmung ging über diagnostische Kategorien hinaus." Kurz gesagt: Unterschiede in kognitiven Verarbeitungsprozessen — und nicht messbarer Hörverlust — scheinen die Schwierigkeiten bei der Herausfilterung von Sprache aus Hintergrundgesprächen zu erklären.

Auf neurokognitiver Ebene bedeutet das Folgendes: Das Herausfiltern einer Zielstimme erfordert schnelle Audiosignaltrennung (Stream Segregation), selektive Aufmerksamkeit, Arbeitsgedächtnis für den temporären Erhalt von Satzteilen sowie gelegentlich visuelle Unterstützung, etwa Lippenablesen. Alle diese Prozesse belasten die kognitive Kapazität, besonders in komplexen akustischen Umgebungen. In der Studie wird hervorgehoben, dass "diese Faktoren die kognitive Belastung beim Kommunizieren unter Lärm erheblich erhöhen".

Aus Sicht der Hörforschung ist wichtig zu verstehen, dass "Sprache-im-Rauschen" (Speech-in-Noise) nicht allein durch die Sensitivität des peripheren Hörsystems bestimmt wird. Vielmehr interagieren sensorische Daten mit höheren kognitiven Funktionen: Aufmerksamkeitssysteme, exekutive Kontrolle und auditive Szenenanalyse arbeiten zusammen, um relevante Sprachströme zu identifizieren und irrelevante Maskierquellen zu unterdrücken.

Die Studie illustriert damit ein zentrales Konzept moderner Audiologie und kognitiver Neurowissenschaft: Hören ist ein aktiver, interpretativer Prozess. Das Gehirn muss eingehende Schallsignale segmentieren, priorisieren und mit früheren Erwartungen sowie sprachlichen Mustern abgleichen. Unterschiede in diesen Prozessen können individuelle Unterschiede im Sprachverstehen unter Lärm erklären, selbst wenn die Ohrgesundheit objektiv unauffällig ist.

Das ist intuitiv nachvollziehbar: Eine einzelne Stimme isolieren erfordert die schnelle Trennung simultaner Audiosignale, die Aufrechterhaltung relevanter Informationen im Arbeitsgedächtnis und die Fokussierung der Aufmerksamkeit auf die richtige zeitliche und frequenzielle Spur. Zusätzlich können visuelle Hinweise wie Lippenbewegungen die auditorische Verarbeitung unterstützen — ein weiterer Grund, warum multimodale Informationen in realen Gesprächen wichtig sind.

Neurophysiologisch spielen dabei Mechanismen wie zeitliche Kodierung (temporal coding), tonotopische Organisation und kortikale Netzwerke für selektive Aufmerksamkeit eine Rolle. Forschung mit Elektroenzephalographie (EEG) und funktioneller Bildgebung hat gezeigt, dass die neuronale Repräsentation einer Zielstimme in der auditorischen Kortextätigkeit stärker ist, wenn Aufmerksamkeit gezielt auf diese Stimme gerichtet wird. Wenn die kognitive Kontrolle schwächer ist, verschlechtert sich die Signal-zu-Rausch-Verstärkung des Zielsignals, was das Verstehen erschwert.

Praktische Implikationen: mehr als ein Hörtest

Die Autorinnen und Autoren der Studie betonen, dass Standard-Audiogramme zentrale, kognitive Ursachen für Hörprobleme übersehen können. Eine Person kann einen "bestandenen" Hörtest haben und trotzdem Mühe haben, einer Unterhaltung in einem belebten Café oder einem Klassenzimmer zu folgen. Diese Erkenntnis hat unmittelbare praktische Konsequenzen für Diagnose, Pädagogik und Interventionen.

Einige kostengünstige, praktikable Maßnahmen, die sich aus den Ergebnissen ableiten lassen, sind:

- Sitzplatzanpassungen im Klassenzimmer: Einen Schüler näher an den Lehrenden setzen kann den Signalanteil der Zielstimme erhöhen und visuelle Hinweise verbessern (Lippenablesen).

- Optimierung der Raumakustik: Absorbierende Materialien, Reduktion von Nachhallzeiten und Schallquellenmanagement können Signalstärke und Sprachverständlichkeit erhöhen.

- Zielgerichtetes auditorisches Training: Programme zur Steigerung selektiver Aufmerksamkeit, auditiver Szenentrennung und Arbeitsgedächtnisleistung können die Verarbeitung von Sprache-im-Rauschen verbessern.

- Einsatz von FM-/Mikrofon-Assistenzsystemen: Technologie, die die Zielstimme direkt verstärkt oder drahtlos überträgt, reduziert die Belastung der kognitiven Systeme.

Solche Interventionen orientieren sich nicht nur an der Peripherie des Hörsystems, sondern adressieren zentrale Verarbeitungsmechanismen, die oft übersehen werden. Besonders für Menschen mit neuroentwicklungsbedingten Unterschieden wie Autismus oder fetalen Alkoholsyndrom können diese Maßnahmen die Teilhabe an Bildung und sozialer Interaktion deutlich verbessern.

Die Forschenden weisen auch auf die Grenzen ihrer Arbeit hin: die vergleichsweise kleine Stichprobengröße und die Verwendung synthetischer statt natürlicher Gespräche. Dennoch tragen die Ergebnisse zu einer wachsenden Evidenzbasis bei, die zeigt, dass Probleme beim Sprachverstehen im Lärm multifaktoriell sind und mit breiteren kognitiven Veränderungen zusammenhängen können. Frühere Studien haben sogar Parallelen zwischen Schwierigkeiten beim Verstehen von Sprache im Lärm und einem erhöhten Demenzrisiko aufgezeigt — ein Hinweis darauf, dass auditive und kognitive Gesundheit langfristig verknüpft sind.

Für Klinikerinnen und Kliniker bedeutet das: Bei Klagen über Hörschwierigkeiten ist es sinnvoll, neben Audiometrie auch kognitive Aspekte, Alltagssituationen und kommunikationsbezogene Belastungen zu evaluieren. Eine umfassende Diagnose kann sowohl audio-periphere als auch zentrale Komponenten erfassen und so individuellere Therapiepläne ermöglichen.

Warum Wissenschaftlerinnen und Wissenschaftler aufmerksam sind

Das Verständnis der neuronalen und kognitiven Grundlagen der Sprachwahrnehmung hat weitreichende Relevanz. Für die Versorgungspraxis verändert es den diagnostischen Blickwinkel auf Hörbeschwerden; für die Pädagogik liefert es Hinweise auf einfache, wirksame Anpassungen, die Verständnis und Lernchancen verbessern; und für Entwicklerinnen und Entwickler von Hörhilfen und Algorithmen hebt es hervor, dass Modelle der Aufmerksamkeitssteuerung und der Szenenanalyse in technische Lösungen integriert werden sollten, nicht nur reine Verstärkungstechniken.

Technologisch gesehen fordert die Studie dazu auf, Algorithmen für Geräuschunterdrückung, Beamforming und Sprachseparation mit kognitiven Modellen zu verbinden. Ein adaptives System, das Nutzenden nicht nur lauter, sondern intelligenter hilft — indem es z.B. die Zielstimme erkennt, auf visuelle Signale reagiert oder sich an Präferenzen anpasst — könnte die kognitive Belastung beim Hören deutlich reduzieren.

Auch in der Prävention und Frühdiagnostik könnte die Kombination aus Hörtests und kognitiven Screenings dazu beitragen, Risiken früh zu identifizieren. Wenn Probleme beim Sprachverstehen im Lärm als frühe Marker systemischer kognitiver Veränderungen gelten, ließen sich gezielte Interventionen früher ansetzen, etwa kognitives Training, soziale Unterstützung oder modifizierte Lernumgebungen.

Abschließend betonen die Autorinnen und Autoren: Man muss keinen messbaren Hörverlust haben, um sich in lauten Alltagsumgebungen erschöpft und verwirrt zu fühlen. Zukünftige Schritte umfassen größere Studien, vielfältigere Teilnehmerstichproben und Interventionsstudien, die direkt auf die Hirnsysteme abzielen, die an der Trennung, Priorisierung und Erinnerung von Sprache beteiligt sind. Solche Arbeiten sind nötig, um klinische Leitlinien, pädagogische Empfehlungen und technologische Lösungen evidenzbasiert weiterzuentwickeln.

Im Sinne der Forschungspraxis wäre es außerdem wertvoll, multimodale Messungen einzubeziehen: Kombinationen aus Audiometrie, kognitiven Tests, EEG/MEG, bildgebenden Verfahren (fMRI) und verhaltensorientierten Sprachverstehensprüfungen in natürlichen Hörsituationen. Damit lassen sich Mechanismen identifizieren, die als Ziele für Rehabilitation, schulische Anpassungen oder technologische Innovation dienen können.

Kurz gesagt: Sprache im Lärm zu verstehen ist ein komplexes Zusammenspiel von peripheren Hörfähigkeiten und zentralen kognitiven Prozessen. Das Bewusstsein für diese Wechselwirkung kann Diagnosen präziser machen, kostengünstige Maßnahmen im Alltag fördern und die Entwicklung von Hörhilfen und Trainingsprogrammen verbessern — mit dem Ziel, Kommunikation in lauten Umgebungen weniger belastend und inklusiver zu gestalten.

Quelle: sciencealert

Kommentar hinterlassen