9 Minuten

Ein japanisches Forschungsteam hat mithilfe künstlicher Intelligenz die bislang detaillierteste Simulation der Milchstraße erstellt — eine Simulation, die mehr als 100 Milliarden einzelne Sterne nachverfolgt und dabei über 100-mal schneller läuft als frühere Ansätze. Indem die Forschenden der KI beibrachten, wie sich Supernovae entwickeln, und dieses Wissen mit großskaliger Physik kombinierten, entstand ein galaktisches Modell, das Jahrzehnte lange Rechenläufe auf Monate verkürzt.

KI hat die erste echte Einzelstern-Simulation der Milchstraße so beschleunigt, dass sie in Monaten statt Jahrzehnten abgeschlossen werden kann.

Wie das Team die Simulationsbarriere überwunden hat

Die Modellierung einer Galaxie wie der Milchstraße mit Einzelstern-Auflösung gilt als eine der größten Herausforderungen in der numerischen Astrophysik. Typische Galaxie-Simulationen müssen konkurrierende Anforderungen ausgleichen: Gravitation, die über Zehntausende von Lichtjahren wirkt; Gasdynamik und Turbulenzen auf sehr kleinen Skalen; sowie kurzlebige, extrem energiegeladene Ereignisse wie Supernova-Explosionen. Üblicherweise vereinfacht man dieses Problem, indem viele Sterne zu einzelnen numerischen Partikeln zusammengefasst werden. Diese Vereinfachung opfert jedoch die kleinskalige Physik, die nötig ist, um zu verstehen, wie Sterne, Gas und neu gebildete schwere Elemente im Laufe kosmischer Zeit miteinander interagieren.

Die von Keiya Hirashima geleiteten Forscher am RIKEN Center for Interdisciplinary Theoretical and Mathematical Sciences (iTHEMS), in Zusammenarbeit mit Wissenschaftlern der University of Tokyo und der Universitat de Barcelona, haben diesen Ansatz grundlegend verändert. Anstatt ausschließlich auf rohe numerische Integration zu setzen, kombinierten sie hochauflösende physikalische Modelle mit einem tiefen Lern-Surrogatmodell, das auf hochaufgelösten Supernova-Simulationen trainiert wurde. Das Surrogatmodell erlernte, wie sich das Gas in den ungefähr 100.000 Jahren nach einer Explosion ausdehnt und entwickelt, und ersetzte damit die rechenintensivsten Teile der Berechnung innerhalb des größeren galaktischen Laufs. Diese hybride Strategie, die Physik mit maschinellem Lernen verknüpft, erlaubt es, mikrophysikalische Prozesse akkurat abzubilden, ohne die gesamte Simulation in jeder Zeitschrittberechnung neu zu lösen.

Technisch basiert das Verfahren auf einer sorgfältigen Auswahl von Trainingsdaten, die typische Supernova-Entwicklungen, Dichten, Temperaturen und Geschwindigkeitsskalen abdecken. Die Forschenden nutzten auflösungsstarke, lokal begrenzte Simulationen der Explosionsdynamik, um das Surrogat zu trainieren, und entwickelten Kopplungsmechanismen, die sicherstellen, dass das gelernte Verhalten konsistent in die großskalige Galaxie-Simulation eingebettet wird. Solche Kopplungsstrategien berücksichtigen Energie- und Impulserhaltung sowie die zeitliche Kohärenz zwischen den auf Mikro- und Makroskala geltenden Prozessen, sodass physikalisch sinnvolle Ergebnisse erhalten bleiben.

Geschwindigkeit ohne Verlust an Genauigkeit

Der Gewinn ist eindrucksvoll: Während eine herkömmliche, rein physikbasierte Simulation etwa 315 Stunden benötigen würde, um eine Million Jahre Milchstraßen-Evolution mit Einzelstern-Auflösung zu berechnen, reduzierte der KI-beschleunigte Ansatz dieses Intervall auf nur 2,78 Stunden. Hochgerechnet bedeutet das: Eine Simulation über eine Milliarde Jahre, die früher mehr als 36 Jahre Rechenzeit erfordert hätte, lässt sich nun in etwa 115 Tagen abschließen. Dieser Leistungssprung — mehr als zwei Größenordnungen — eröffnet neue Möglichkeiten, die Entstehung von Galaxien, stellare Dynamik und die chemische Anreicherung mit bisher unerreichter Reichweite zu untersuchen.

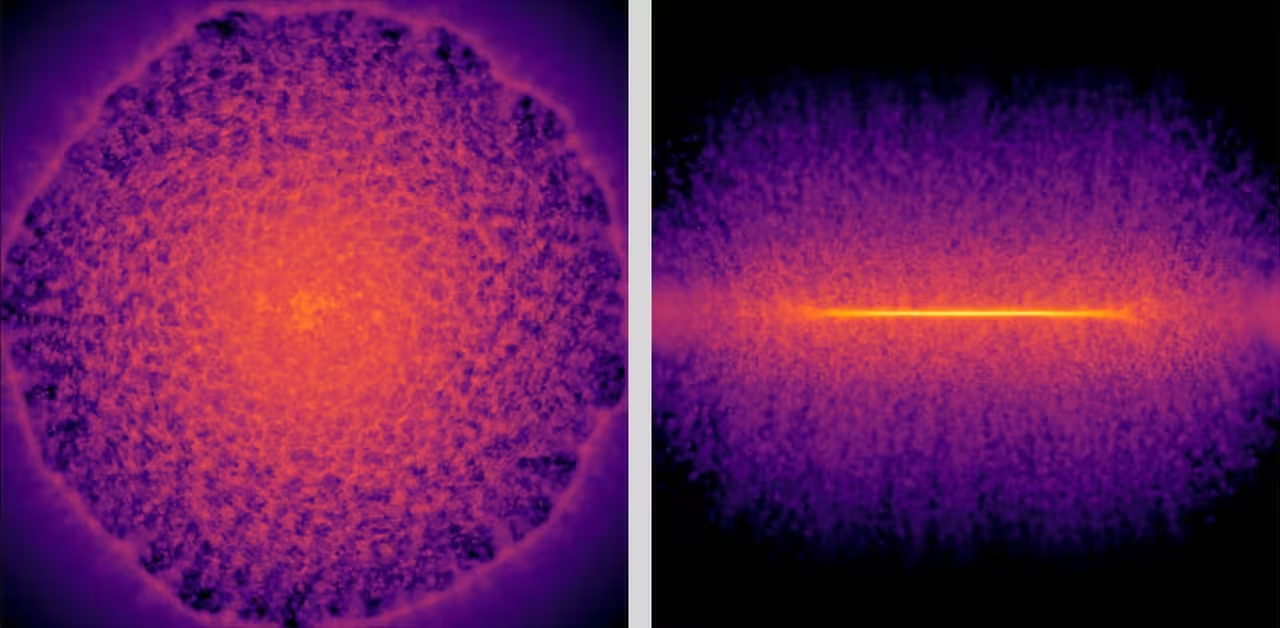

Frontale (links) und Seitenansicht (rechts) von Schnappschüssen einer galaktischen Gasscheibe. Diese Darstellungen der Gasverteilung nach einer Supernova-Explosion wurden vom Deep-Learning-Surrogatmodell erzeugt.

Wichtig ist hierbei die Balance zwischen Geschwindigkeit und physikalischer Stringenz: Das Surrogat ersetzt nur jenen Teil der Mikrophysik, der am meisten Rechenzeit beansprucht, während grundlegende großskalige Kräfte und Wechselwirkungen weiterhin explizit durch klassische Numerik gelöst werden. Durch diese Aufgabenteilung werden sowohl Konvergenztests als auch Validierungen gegenüber Standardlösungen möglich, sodass die Simulation nicht nur schnell, sondern auch wissenschaftlich belastbar bleibt.

Warum die Verfolgung einzelner Sterne wichtig ist

Die Nachverfolgung einzelner Sterne — anstelle von Sternhaufen, die durch einzelne Partikel repräsentiert werden — bewahrt die kleinskaligen Prozesse, die die Entwicklung einer Galaxie antreiben. Supernovae injizieren Energie und schwere Elemente in das umgebende Gas, was lokale Bedingungen für die Gasabkühlung, die Druckverhältnisse und damit die Sternentstehung entweder ankurbeln oder unterdrücken kann. Diese Effekte spielen sich auf kurzen Zeitskalen und in begrenzten Volumina ab; nur ein Modell mit feiner Auflösung kann zeigen, wie sie sich additiv zu großräumigen Strukturen zusammenfügen und damit die Morphologie einer Galaxie über Millionen bis Milliarden von Jahren formen.

Mit Einzelstern-Auflösung können Astrophysiker simulierte stellare Bahnen, Altersverteilungen und chemische Fingerabdrücke direkt mit Beobachtungsdaten aus Projekten wie der Satellitenmission Gaia, kombinierten Photometrie- und Spektroskopie-Umfragen sowie künftigen spektroskopischen Kampagnen vergleichen. Das erhöht die Aussagekraft von Modellen zur Entstehung der Milchstraße, erlaubt genauere Rückschlüsse auf vergangene Verschmelzungen mit Zwerggalaxien und unterstützt Untersuchungen zur Herkunft lebenswichtiger Elemente wie Kohlestoff, Sauerstoff oder Eisen. Solche Vergleiche sind zentral für die Stellararchäologie und die Rekonstruktion der Galaxienbildungs-Historie.

Darüber hinaus schafft Einzelstern-Modellierung eine Grundlage für die Untersuchung spezifischer Szenarien: Wie beeinflussen lokale Sternentstehungsausbrüche die Rotation einer Scheibe? Welche Rolle spielen nahe Supernovae bei der Ausprägung von Räumen mit niedriger Metallizität? Solche Fragen lassen sich nur mit hoher räumlicher und zeitlicher Auflösung beantworten und sind für die Interpretation von Beobachtungen und die Planung künftiger Missionen von großer Relevanz.

Technische Validierung und breitere Auswirkungen

Das Team validierte die hybride Methode durch umfangreiche Tests auf groß angelegten Rechneranlagen wie dem Fugaku-Supercomputer des RIKEN und dem Miyabi Supercomputer System der University of Tokyo. Die Vergleiche bestätigten, dass das Surrogatmodell zentrale physikalische Verhaltensweisen beibehält und gleichzeitig die Rechenkosten drastisch senkt. Solche Validierungen umfassten Vergleichsmessungen von Energieerhaltung, Schockausbreitung, Dichten und Temperaturprofilen sowie statistische Tests hinsichtlich der Verteilung erzeugter Metallizität in der Umgebung von Supernova-Regionen.

Über die Galaxienmodellierung hinaus könnte dieses hybride Paradigma — bei dem KI als vertrauenswürdiges Surrogat für die teuersten Mikroprozesse dient — Multi-Skalen-Simulationen in Bereichen wie Klimamodellierung, Ozeanographie oder Wettervorhersage grundlegend verändern. In diesen Disziplinen treten ähnliche Herausforderungen auf: gekoppelte Prozesse, die auf sehr unterschiedlichen räumlichen und zeitlichen Skalen liegen und enorme Rechenressourcen erfordern. Eine zuverlässige Surrogatstrategie kann dort ebenso zu Effizienzgewinnen führen und Modellläufe ermöglichen, die bisher unpraktikabel erschienen.

Hirashima betonte die größere Bedeutung dieser Entwicklung: „Ich glaube, dass die Integration von KI mit Hochleistungsrechnen einen grundlegenden Wandel markiert in der Art und Weise, wie wir multi-skalen und multi-physikalische Probleme in den rechnerischen Wissenschaften angehen. Dieser Erfolg zeigt zudem, dass KI-beschleunigte Simulationen über Mustererkennung hinauswachsen und zu einem echten Werkzeug der wissenschaftlichen Entdeckung werden können — sie helfen uns nachzuzeichnen, wie die Elemente, aus denen Leben entstand, in unserer Galaxie entstanden sind.“

Wesentliche wissenschaftliche Implikationen

- Galaxienentwicklung: Schnelle, hochauflösende Simulationen ermöglichen umfangreichere Parameterstudien zur Prüfung konkurrierender Entstehungsszenarien für die Milchstraße und andere Spiralgalaxien.

- Sternenarchäologie: Die Verfolgung einzelner Sterne verbessert den Vergleich mit Beobachtungskatalogen und unterstützt Rekonstruktionsbemühungen zur Mergers-Historie der Galaxie.

- Chemische Anreicherung: Detaillierte Supernova-Feedback-Modelle erlauben es, die Produktion und Verteilung schwerer Elemente über kosmische Zeit detailliert nachzuverfolgen.

- Interdisziplinäres Potenzial: Die KI-Surrogat-Strategie kann rechnerisch anspruchsvolle Probleme in der Erdwissenschaft, Klimasimulation und anderen Gebieten beschleunigen.

Diese Implikationen betreffen nicht nur die Grundlagenforschung, sondern auch die praktische Planung zukünftiger Beobachtungsprogramme: realistische synthetische Himmelsdurchmusterungen (Mock Surveys) können schneller erzeugt werden und so helfen, Instrumentenspezifikationen, Blickfeld-Strategien und Zielkataloge zu optimieren. Das erhöht die Effizienz realer Missionen und die wissenschaftliche Ausbeute aus begrenzter Observierungszeit.

Was das System noch nicht leistet — vorerst

Trotz des Durchbruchs bleiben Herausforderungen. Die aktuelle Demonstration deckt 10.000 Jahre mit Einzelstern-Granularität innerhalb eines galaktischen Rahmens ab und extrapoliert die erreichten Zeitgewinne auf Millionen- und Milliardenjahreszeiträume. Die Integration zusätzlicher wichtiger Physik — etwa kosmischer Strahlen (Cosmic Rays), Magnetfelder auf feinen Skalen, oder die vollständige Behandlung des Strahlungstransports — erfordert jedoch weitere Entwicklung sowohl der Trainingsdaten für Surrogate als auch der Kopplungsstrategien. Insbesondere die Modellierung von magnetohydrodynamischen Effekten (MHD) in Verbindung mit Strahlung und teilchenphysikalischen Prozessen bleibt rechenintensiv und anspruchsvoll.

Weitere praktische Probleme betreffen die Energieeffizienz und die Skalierbarkeit auf unterschiedlichen Supercomputing-Architekturen. Der effektive Einsatz in regelmäßigen Produktionsläufen verlangt robuste Optimierungen, Portierbarkeit des Codes und Tests auf heterogenen Systemen, die GPUs, spezielle Beschleuniger oder unterschiedliche Speicherhierarchien nutzen. Ferner sind verlässliche Unsicherheitsabschätzungen und methodische Frameworks für das Training des Surrogats notwendig, um systematische Fehler zu vermeiden.

Expertenkommentar

Dr. Laura Méndez, Astrophysikerin und Computational Scientist (fiktiv), kommentierte: „Diese Arbeit ist ein Meilenstein, weil sie das Rechen-Dilemma neu formuliert. Anstatt zu fragen, wie viel Hardware wir auf ein Problem werfen können, fragen wir, wie intelligent wir die kostenintensivste Physik durch gelernte, verlässliche Approximationen ersetzen können. Das hat Nachwirkungen: mehr Experimente, mehr Parameter-Sweeps und letztlich schnellere wissenschaftliche Entdeckungen.“

Zukünftige Perspektiven

Mit Blick auf die Zukunft könnte der hybride KI-plus-HPC-Ansatz auf die Simulation anderer Galaxientypen ausgeweitet werden, Sternentstehungsgeschichten in unterschiedlichen Umgebungen analysieren und Beobachtungsmissionen durch die Erzeugung realistischer Mock Surveys unterstützen. Wenn Trainingsdatensätze wachsen und Surrogatmodelle an Genauigkeit gewinnen, dürfte die Balance zwischen Präzision und Geschwindigkeit weiterhin zugunsten der Forschenden verschoben werden. Das eröffnet die Möglichkeit für häufigere, tiefere Untersuchungen der kosmischen Geschichte, die in den Sternen geschrieben steht.

Zusätzlich können Entwicklungen in Explainable AI (erklärbare KI) und Unsicherheitsquantifizierung dazu beitragen, das Vertrauen in Surrogatmodelle zu stärken und ihre Akzeptanz in der wissenschaftlichen Gemeinschaft zu erhöhen. In Kombination mit offenen Datenstandards, Reproduzierbarkeits-Praktiken und community-getriebenen Benchmarking-Initiativen besteht das Potenzial, diese Methoden schnell in der astrophysikalischen Forschung zu verbreiten und neue Kooperationen zwischen Domänen wie Informatik, Astrophysik und Hochleistungsrechnen zu fördern.

Quelle: scitechdaily

Kommentar hinterlassen