7 Minuten

Neue Forschungsergebnisse der University of Birmingham zeigen, dass autistische und nicht-autistische Menschen ihr Gesicht bei Gefühlsäußerungen wie Ärger, Freude oder Traurigkeit auf unterschiedliche Weise bewegen. Diese Unterschiede können dazu führen, dass emotionale Signale von beiden Gruppen missverstanden werden — nicht weil eine Seite falsch liegt, sondern weil die nonverbale „Sprache“ unterschiedlich ist.

Wissenschaftler fanden heraus, dass autistische und nicht-autistische Personen Gesichtszüge unterschiedlich einsetzen, um Emotionen wie Ärger, Freude und Traurigkeit auszudrücken. Diese Unterschiede könnten erklären, warum emotionale Signale zwischen den Gruppen häufig missverstanden werden.

Mapping facial motion: a high-resolution look at expression

Mit hochauflösendem Gesichtsmotion-Tracking erstellten die Forschenden eine differenzierte Referenz dafür, wie Menschen körperlich grundlegende Emotionen formen. Die Studie — veröffentlicht in Autism Research — sammelte fast 5.000 einzelne Ausdrücke von 25 autistischen Erwachsenen und 26 nicht-autistischen Erwachsenen und erzeugte mehr als 265 Millionen Datenpunkte. Diese Dichte erlaubte es dem Team, über einfache Kategorien hinauszugehen und die feingliedrigen Mechaniken der Mimik zu untersuchen: welche Muskeln sich bewegen, wie schnell die Bewegungen ablaufen und in welchen Kombinationen sie auftreten.

Technisch basierte die Analyse auf präziser Bewegungsregistrierung von Gesichtspunkten (landmarks) und Schlüsselregionen, kombiniert mit zeitlicher Auflösung, die Submillimeter-Änderungen und Millisekunden-Dynamiken erfassen kann. Dieses methodische Vorgehen ermöglicht Aussagen über die Aktivität einzelner Muskelgruppen, die im Fachjargon oft mit dem Facial Action Coding System (FACS) beschrieben werden — etwa Zygomaticus- oder Orbicularis-Oculi-Bewegungen — ohne sich ausschließlich auf einfache Labels wie „Lächeln“ zu beschränken.

How the experiment worked and what it revealed

Die Teilnehmenden wurden gebeten, Ärger, Freude und Traurigkeit in zwei Situationen zu zeigen: einmal durch das Nachahmen von Lauten (Stimulus-Matching) und einmal während des Sprechens. Dieser duale Ansatz ermöglichte es den Forschenden, sowohl gestellte als auch eher spontane mimische Reaktionen zu erfassen — also das Spektrum von absichtlicher Mimik bis zu natürlichen, sprachbegleiteten Gesten.

Die Auswertung nutzte statistische Modelle und Mustererkennung, um wiederkehrende Unterschiede zu identifizieren. Dabei traten stabile, interpretierbare Unterschiede in der Nutzung von Gesichtsregionen zutage, die sich zwischen den Gruppen konsistent zeigten und nicht allein durch Zufall erklärbar waren. Solche Befunde helfen, die Mechanik hinter Missverständnissen in der nonverbalen Kommunikation besser zu verstehen.

Key movement differences

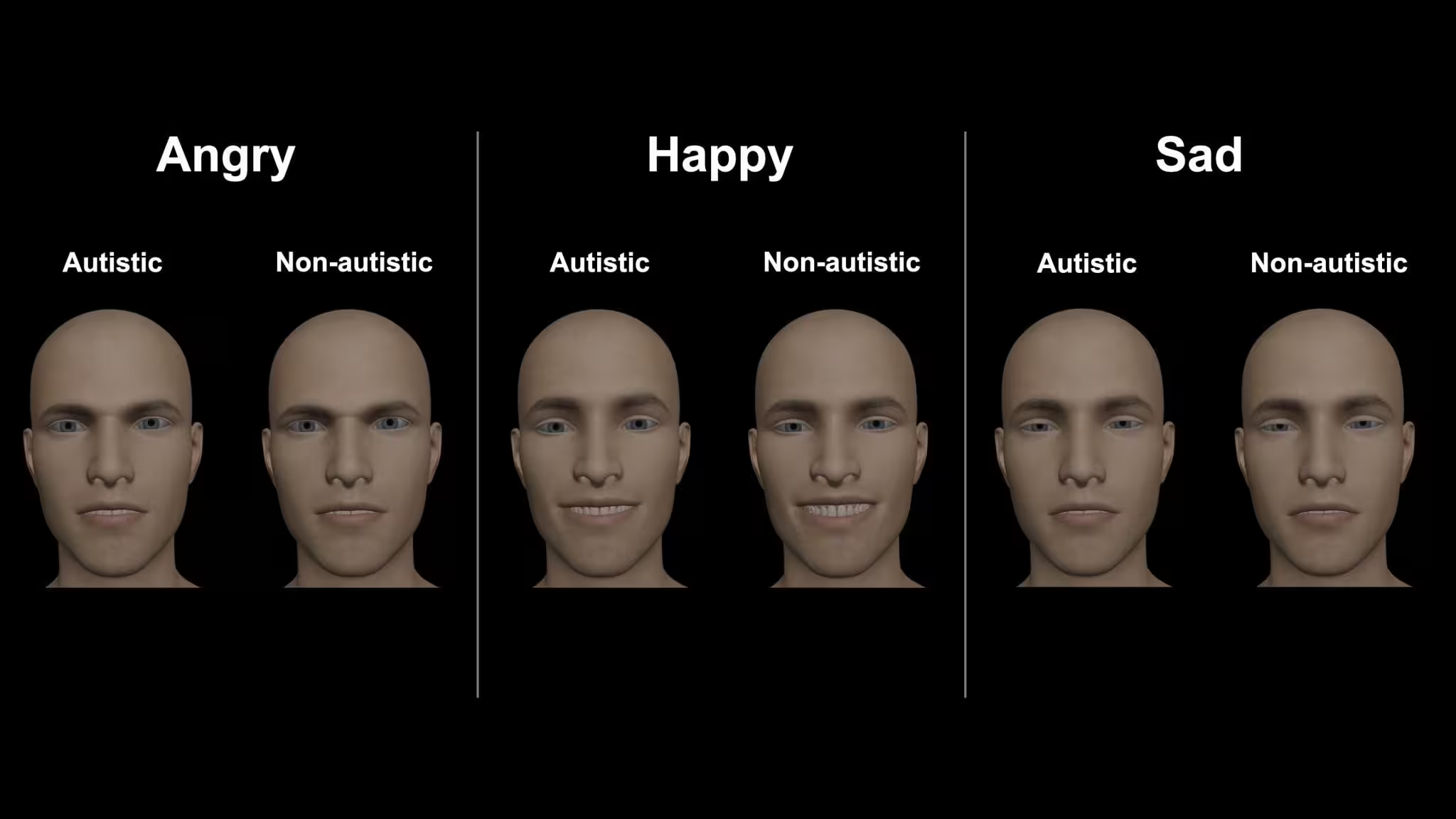

- Ärger: Bei autistischen Teilnehmenden traten häufiger Mundbewegungen in den Vordergrund, während Aktivitäten im Brauenfeld (z. B. Zusammenziehen der Stirnmuskulatur) seltener waren als bei nicht-autistischen Teilnehmenden.

- Freude: Lächeln bei autistischen Personen wirkten oft subtiler und betrafen seltener die Augenregion — das klassische „Lächeln, das in die Augen reicht“ (orbicularis-oculi-Beteiligung) war weniger verbreitet.

- Traurigkeit: Autistische Ausdrücke beinhalteten häufig ein gehobenes oberes Lippenfeld, das zu einem abgesenkten Gesamteindruck beiträgt — ein Muster, das in nicht-autistischen Gesichtern weniger ausgeprägt war.

Diese Unterschiede betreffen sowohl die räumliche Verteilung (welche Regionen des Gesichts aktiviert werden) als auch die zeitliche Struktur (wie schnell eine Bewegung beginnt, wie fließend sie sich entwickelt und wie lange sie anhält). Solche Details sind für die Interpretation von Mimik zentral und erklären, warum Beobachterinnen und Beobachter manchmal verschiedene Emotionen aus demselben Gesicht „lesen“.

Alexithymia: a complicating factor

Die Forschenden untersuchten außerdem Alexithymie — ein Persönlichkeitsmerkmal, das durch Schwierigkeiten beim Erkennen und Beschreiben eigener Gefühle gekennzeichnet ist und gehäuft bei autistischen Menschen auftritt. Höhere Alexithymie-Werte korrelierten in der Studie mit weniger klar definierten mimischen Signalen für Ärger und Freude; diese Ausdrücke wirkten gemischter oder ambivalenter.

Das legt nahe, dass ein Teil der Variabilität in der Mimik nicht nur direkt mit Autismus zusammenhängt, sondern mit individuellen Unterschieden in der emotionalen Selbstwahrnehmung. Für Forschung und Praxis bedeutet das, dass Diagnose und Interpretation von Mimik mehrere Ebenen berücksichtigen müssen: neurologische/entwicklungsbezogene Merkmale, traits wie Alexithymie und situative Faktoren.

Why misreading goes both ways

Leitender Forscher Dr. Connor Keating (mittlerweile an der University of Oxford) und Kolleginnen und Kollegen betonen die Reziprozität des Problems: Es sind nicht nur autistische Personen, die Schwierigkeiten haben, nicht-autistische Gesichtsausdrücke korrekt zu erkennen — auch nicht-autistische Beobachtende tun sich oft schwer mit autistischen mimischen Signalen. Die Studie verweist auf Unterschiede sowohl in der visuellen Erscheinung als auch in der Geschmeidigkeit der Formung von Ausdrücken als wahrscheinliche Ursachen.

In der Praxis bedeutet das, dass Kommunikationsprobleme selten einseitig sind. Vielmehr kann man von „unterschiedlichen nonverbalen Dialekten“ sprechen: Zwei Menschen verwenden dieselben Werkzeuge (Mimik, Gestik, Stimme), aber kombinieren sie unterschiedlich. Solche Dialekte sind weder korrekt noch fehlerhaft per se — sie sind alternative Systeme der Emotionsdarstellung, die gegenseitiges Lernen und Anpassung erfordern.

Implications for communication, technology and support

Die Ergebnisse haben praktische Relevanz über die reine Forschungsfrage hinaus. Für Klinikerinnen und Therapeuten kann ein vertieftes Verständnis unterschiedlicher mimischer Muster zu präziseren Diagnosen und einer geringeren Fehlinterpretation in klinischen Gesprächen führen. Bei diagnostischen Einschätzungen sollten Fachleute neben standardisierten Tests auch multimodale Informationen berücksichtigen — z. B. Kontext, Verbalisierungen und Berichte von Angehörigen.

Für Entwicklerinnen und Entwickler von Emotionserkennungssoftware und sozialen Robotern weisen die Befunde auf ein Bias-Risiko hin: Algorithmen, die auf einem engen Spektrum von Gesichtern trainiert wurden, können autistische Ausdrucksformen falsch klassifizieren oder ignorieren. Das unterstreicht die Notwendigkeit diverser Trainingsdaten, die unterschiedliche Altersgruppen, kulturelle Hintergründe und neurologische Variationen einschließen.

Im Alltag kann das Wissen um unterschiedliche Gesichtsdialekte gedanklich zu mehr Toleranz und aktiver Anpassung führen. Einfache Strategien wie Nachfragen („Wie meinst du das?“), längere Beobachtungszeit und explizite Rückmeldung können Missverständnisse reduzieren. Zugleich ist wichtig, nicht-autistische Menschen zu ermutigen, autistische Ausdrucksweisen nicht pathologisierend zu bewerten, sondern als valide Varianten nonverbaler Kommunikation anzuerkennen.

Darüber hinaus haben die Ergebnisse Auswirkungen auf Ausbildung und Public-Health-Maßnahmen: Sensibilisierungskampagnen, Fortbildungen für Lehrkräfte und Gesundheitspersonal sowie inklusionsorientierte Designprinzipien in der Technikentwicklung können Barrieren verringern und die soziale Teilhabe verbessern.

What’s next?

Die Autorinnen und Autoren der Studie prüfen bereits, ob Trainingsinterventionen oder veränderte Kontexte Missverständnisse verringern können und ob gezielte Aufklärungsmaßnahmen die gegenseitige Erkennung zwischen autistischen und nicht-autistischen Personen verbessern. Solche Interventionsstudien könnten sowohl Perzeptionsübungen (z. B. Training zur Gesichtserkennung) als auch Kontext-Modifikationen (z. B. veränderte Gesprächsregeln, langsamere Interaktionsgeschwindigkeit) umfassen.

Professorin Jennifer Cook von der University of Birmingham betont: Wenn Unterschiede als alternative — nicht als defizitäre — Ausdruckssysteme verstanden werden, eröffnen sich neue Wege für Forschung, Inklusion und technologisches Design, das Diversität in der Emotionssignalisierung respektiert. Folgeprojekte sollten die Stichprobe vergrößern, kulturelle Unterschiede einbeziehen und Altersgruppen über Adulthood hinaus untersuchen, um Generalisierbarkeit und praktische Anwendbarkeit zu erhöhen.

Weitere Forschungsempfehlungen umfassen:

- Longitudinalstudien, die Entwicklungsverläufe von Mimik und emotionaler Kommunikation über die Lebensspanne verfolgen.

- Interdisziplinäre Ansätze, die Psychologie, Neurowissenschaften, Informatik (insbesondere Machine Learning) und Sozialwissenschaften kombinieren.

- Experimente mit natürlicher Interaktion (z. B. in Gruppensituationen), um ökologische Validität zu steigern.

- Methodische Standardisierung zur Vergleichbarkeit von Ergebnissen, etwa durch offene Datensätze und reproduzierbare Analysepipelines.

Insgesamt liefert die Studie eine differenzierte, datenreiche Grundlage, um Missverständnisse in der sozialen Kommunikation besser zu erklären und anzugehen — sei es in klinischen, technologischen oder alltäglichen Kontexten.

Für Interessierte an praktischen Anwendungen bedeutet dies: Beim Design von Trainingsprogrammen für soziale Fertigkeiten, beim Erstellen inklusiver KI-Modelle oder bei therapeutischen Interventionen sollte die Vielfalt mimischer Ausdrucksweisen anerkannt und berücksichtigt werden. Nur so lassen sich Kommunikationsbarrieren nachhaltig abbauen.

Quelle: scitechdaily

Kommentar hinterlassen