8 Minuten

Ein Algorithmus hat Jahrzehnte von Hubble-Beobachtungen in eine Art Schatzkarte des Unerwarteten verwandelt. Innerhalb weniger Tage durchforstete ein Tool des maschinellen Lernens nahezu 100 Millionen Bildausschnitte und förderte mehr als tausend Objekte zutage, die auf den ersten Blick wie Kuriositäten erscheinen — bei genauerer Betrachtung aber wie Chancen für neue astrophysikalische Erkenntnisse.

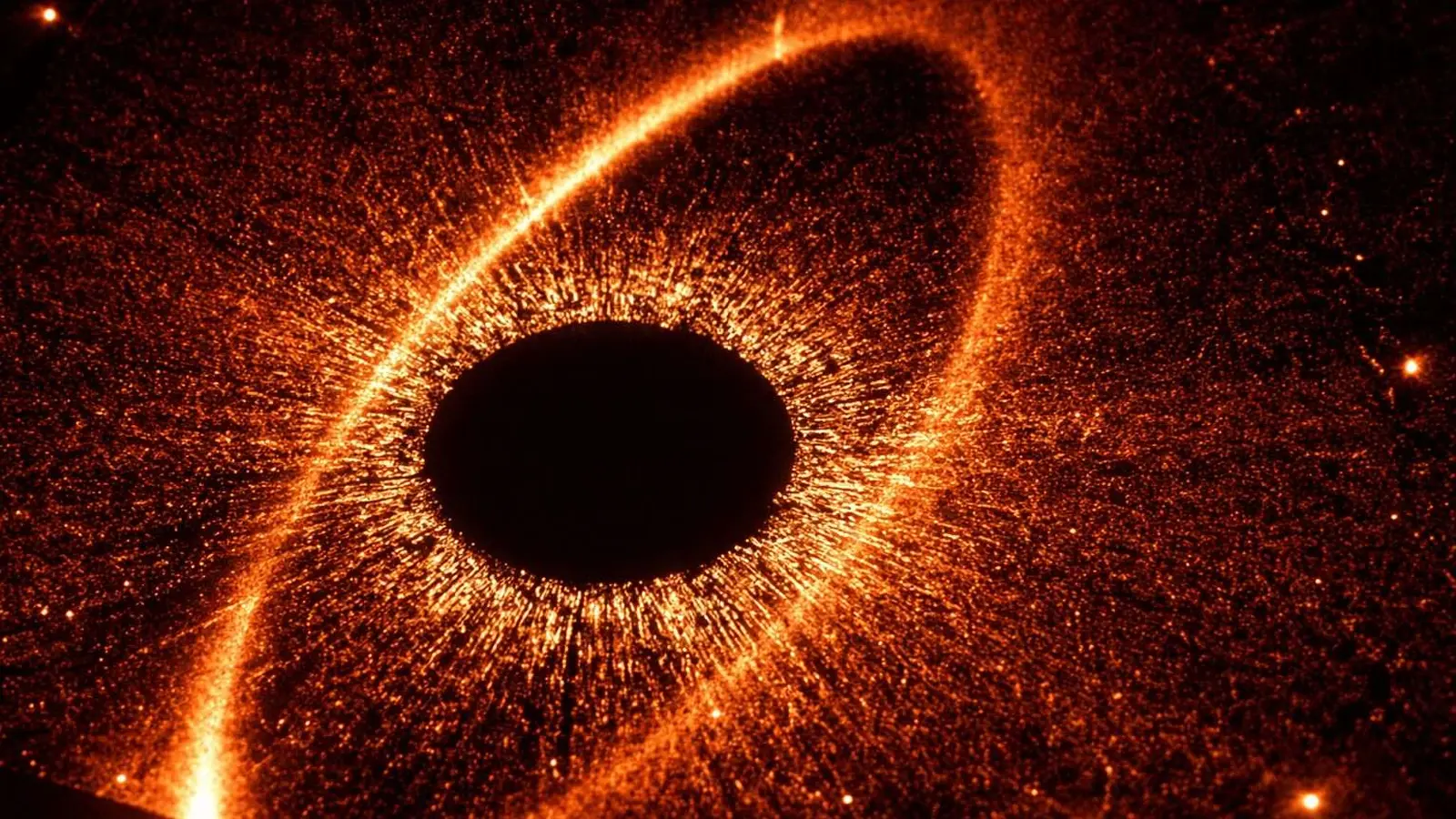

Sechs zuvor unentdeckte, ungewöhnliche und faszinierende astrophysikalische Objekte werden in diesem neuen Bild vom Hubble-Weltraumteleskop gezeigt. (NASA, ESA, David O'Ryan (ESA), Pablo Gómez (ESA), Mahdi Zamani (ESA/Hubble))

Wie die Suche funktionierte

Das Hubble-Bildarchiv reicht zurück auf etwa 35 Jahre Beobachtungen. Es ist riesig, heterogen und in seiner Struktur noch stark durch menschliche Entscheidungen geprägt — Eigenschaften, die die Entdeckung neuer Objekte heute bremsen können. Moderne Instrumente wie das James Webb Space Telescope (JWST) und das künftig in Betrieb gehende Vera Rubin Observatory erzeugen enorme Datenmengen — in Einzelfällen Terabytes pro Nacht — und das Hubble Legacy Archive liegt unter dieser Datenflut als ein immer noch wenig vollständig erschlossenes Reservoir wichtiger Informationen.

Hier kommt AnomalyMatch ins Spiel: ein halbüberwachtes Anomalie-Erkennungs-Framework, aufgebaut auf zeitgemäßen neuronalen Netzen. Anders als klassische Klassifikatoren, die darauf trainiert sind, eine feste Menge bekannter Objekttypen zu erkennen, markiert AnomalyMatch Beispiele, die von den aus dem Archiv selbst gelernten Erwartungsmustern abweichen. Das Team um David O'Ryan und Pablo Gómez bei der ESA fütterte das System mit rund 100 Millionen Hubble-Cutouts. Das Ergebnis war eine nach Relevanz geordnete Shortlist von Anomalie-Kandidaten, die Menschen realistisch überprüfen können.

Ein entscheidender Vorteil ist die Geschwindigkeit: Die Entwickler berichten, dass AnomalyMatch den Datensatz in etwa zwei bis drei Tagen auf einer einzelnen GPU verarbeitete — eine Aufgabe, die für menschliche Teams deutlich länger dauern würde. Geschwindigkeit allein reicht aber nicht: Ohne sinnvolle Kuratierung wäre die Ausgabe überwiegend Rauschen. Das neuronale Netz reduzierte die Menge auf eine handhabbare Liste von etwa 1.400 Kandidaten, die Astronominnen und Astronomen visuell verifizieren konnten.

Technisch basiert die Lösung auf einer Kombination aus selbstüberwachtem Feature-Learning, Clustering in Feature-Räumen und einer Rangfolge-Metrik, die seltene oder ungewöhnliche Repräsentationen hervorhebt. Solche halbüberwachten Ansätze erlauben es, Strukturinformationen aus unlabeled Daten zu extrahieren — ein zentraler Vorteil, wenn es kaum vollständig annotierte Trainingsdaten für exotische astrophysikalische Phänomene gibt. Darüber hinaus lässt sich das System so parametrisieren, dass Biases durch Instrumenteneigenschaften, Belichtungszeiten oder Filterwechsel minimiert werden.

Entdeckungen und wissenschaftlicher Wert

Aus der Shortlist bestätigten O'Ryan und Gómez etwa 1.300 echte Anomalien. Mehr als 800 davon scheinen zuvor nicht dokumentiert worden zu sein. Was spülte die KI an die Oberfläche? Eine große Vielfalt astrophysikalischer Objekte und Morphologien: dominierend waren interagierende und verschmelzende Galaxien — 417 solcher Systeme wurden identifiziert. Das Archiv lieferte außerdem 86 neue Kandidaten für Gravitationslinsen — Systeme, bei denen ein massereiches Vordergrundobjekt das Licht einer dahinter liegenden Quelle krümmt.

Gravitationslinsen sind weit mehr als bloße Kuriositäten. Sie fungieren als natürliche Teleskope, verstärken schwache oder weit entfernte Galaxien und ermöglichen es Forschenden, die Verteilung der Dunklen Materie zu untersuchen, Entfernungen zu verfeinern und Aspekte der Allgemeinen Relativität auf kosmischen Skalen zu testen. Die neuen Linsen-Kandidaten könnten darüber hinaus seltene Massendislokationen oder ungewöhnliche Massenprofilen aufzeigen, die wichtige Hinweise auf Substruktur in Dunkler Materie geben.

AnomalyMatch identifizierte außerdem Raritäten wie Quallengalaxien — Galaxien in Galaxienhaufen, die Gas verlieren, während sie durch ein dichtes Medium rasen und sternbildende Filamente hinter sich herziehen — sowie mehrere Ring- und Kollision-Ring-Galaxien. Das System fand Objekte knapp an der Nachweisgrenze von Hubble: hochrotverschobene Systeme, deren schwache Signale sorgfältige Nachprüfung erfordern. Auch jettende aktive galaktische Kerne (AGN) und ungewöhnliche AGN‑Wirt‑Konfigurationen gehörten zu den Funden, ebenso überlagerte, klumpige und morphologisch eigenartige Galaxien.

Eine Anomalie aus Hubbles Archiv, klassifiziert als eine "kollisionsbedingte Ring"-Galaxie — eine von nur zwei gefundenen Exemplaren. (ESA/Hubble & NASA, D. O'Ryan, P. Gómez (European Space Agency), M. Zamani (ESA/Hubble))

Warum lohnt es sich, Anomalien zu suchen? Weil Ausreißer oft am meisten lehren. Sie öffnen Einblicke in physikalische Regime oder Entwicklungswege, die von Standard‑Surveys und üblichen Selektionsalgorithmen übersehen werden. Eine seltene Wechselwirkung, eine ungewöhnlich austhermte Galaxie oder eine Linse mit asymmetrischer Massenverteilung — solche Objekte können Folgebeobachtungen anstoßen, die zu neuen astrophysikalischen Einsichten führen. Beispielsweise können spektroskopische Messungen Rotverschiebungen und kinematische Informationen liefern, die helfen, Masseprofile zu rekonstruieren; hochauflösende Nachbeobachtungen mit Teleskopen wie dem JWST oder den größten bodengebundenen Instrumenten können Morphologie und Sternentstehungsraten auflösen.

Die Bandbreite der gefundenen Anomalien macht deutlich, dass das Hubble‑Archiv eine Schatzkammer für serendipitäre Entdeckungen bleibt. Gleichzeitig zeigt die Arbeit, wie wichtig interdisziplinäre Pipelines sind: Bildverarbeitung, maschinelles Lernen und astrophysikalische Interpretation müssen Hand in Hand gehen, um das volle wissenschaftliche Potenzial auszuschöpfen.

Kontext: Archive, Teleskope und die Datenflut

Hubbles Archiv ist nur eine Schicht in einem deutlich größeren Datenökosystem. Das James Webb Space Telescope erzeugt je nach Beobachtungsprogramm täglich mehrere zehn Gigabyte an Rohdaten. Das Vera Rubin Observatory wird die Datenmengen weiter in die Höhe treiben und voraussichtlich rund 20 Terabyte Rohdaten pro Nacht liefern, sobald es vollständig in Betrieb ist. Große bodengebundene Observatorien wie das Giant Magellan Telescope (GMT) und das Extremely Large Telescope (ELT) werden Tiefe und räumliche Auflösung verstärken — sie werden allerdings den Datenstrom nicht verringern.

Menschen allein können diese Flut nicht mehr vollständig durchmustern. Hier kommen maschinelle Priorisierungen ins Spiel: Algorithmen können die Daten vorfiltern, Objekte nach Auffälligkeit oder wissenschaftlichem Potenzial ranken und damit die Arbeit für Beobachterteams fokussieren. Die Kombination aus algorithmischer Triage und menschlicher Interpretation etabliert sich zunehmend als praxisorientierte Arbeitsweise: KI fängt das Grobe, Wissenschaftlerinnen und Wissenschaftler kümmern sich um die feine Sortierung, physikalische Modellierung und kontextuelle Bewertung.

Ein Beispiel: ein automatisches System markiert eine Liste von Linsen‑Kandidaten; Beobachterteams wählen daraus Prioritäten für Follow‑up‑Spektroskopie, hochauflösende Bildgebung oder Monitoring. So entstehen effiziente Feedback‑Schleifen, in denen menschliche Expertise die algorithmischen Vorschläge verifiziert und die Modelle mit neuen, geprüften Daten weiter trainiert werden. Die Hubble‑Studie ist ein konkreter Beleg dafür: Ein bestehendes Archiv, neu analysiert mit modernen Werkzeugen, förderte hunderte wissenschaftlich interessante Objekte zutage, die zuvor übersehen worden waren.

Experteneinschätzung

"Diese Arbeit zeigt, wie algorithmische Suche die wissenschaftliche Ausbeute archivalischer Daten dramatisch erhöhen kann", sagt Dr. Leila Banerjee, eine beobachtende Kosmologin an der University of Cambridge. "Anomalieerkennung ersetzt keine hypothesengesteuerte Wissenschaft; sie ergänzt sie, indem sie auf Regionen des Parameterraums hinweist, die wir sonst möglicherweise nie untersuchen würden. Das Spannendste ist, dass viele dieser Kandidaten ideale Ziele für Spektroskopie und hochauflösende Nachbeobachtungen sein werden — die Arten von Messungen, die Anomalien in physikalische Erkenntnisse verwandeln."

Das Forschungsteam betont, dass die Methode skalierbar ist. Die Architektur von AnomalyMatch ist auf großflächige Einsätze ausgelegt, sodass ähnliche Suchen auf anderen Archiven wie ESA's Gaia‑Daten oder kombinierten Hubble‑plus‑JWST‑Datensätzen durchgeführt werden können. Mit der Verbesserung von Modellen und der Verknüpfung multiwellenlängenreicher Archive wächst das Potenzial, tatsächlich neuartige Phänomene zu entdecken.

Praktische nächste Schritte sind klar: Kataloge neu markierter Hubble‑Anomalien bieten einen reichen Ausgangspunkt — Kandidaten für die Bestätigung als Gravitationslinsen, rätselhafte Morphologien, die dynamische Modellierung erfordern, und Randfälle, die mit gezielten Beobachtungen klarer werden könnten. Instrumentelle Follow‑ups, insbesondere spektroskopische Messungen zur Bestimmung von Rotverschiebung und Dynamik, sind oft der Schlüssel, um Anomalien in fundierte astrophysikalische Interpretationen zu überführen.

Kurz gesagt: Das Archiv hat offenbar noch Überraschungen parat — wenn man weiß, wo man suchen muss, und die richtigen Werkzeuge zur Hand hat, um die interessantesten Fälle herauszufiltern. Welche Teams die Nachbeobachtungen übernehmen, wird darüber entscheiden, welche dieser Kuriositäten zu Durchbrüchen und welche zu Fußnoten in der Forschungsgeschichte werden.

Quelle: sciencealert

Kommentar hinterlassen