10 Minuten

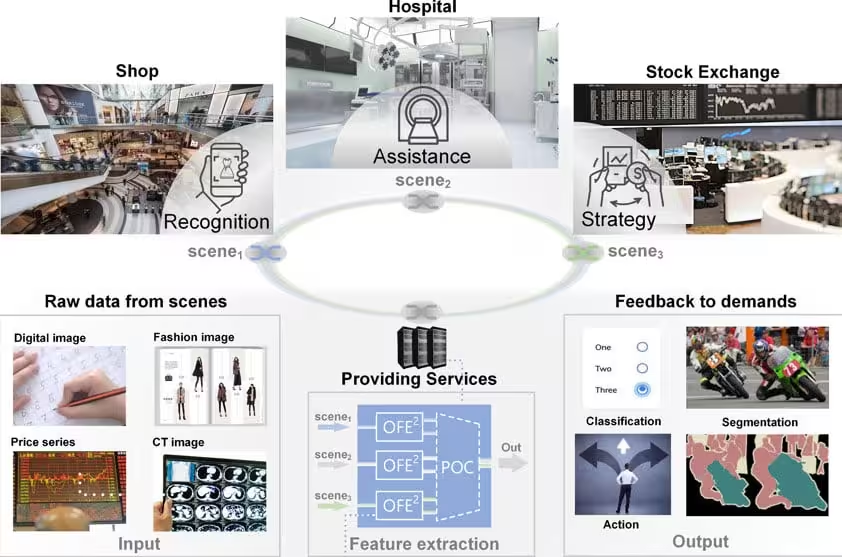

Forscher der Tsinghua-Universität haben einen integrierten optischen Rechenchip vorgestellt, der die Geschwindigkeit bei der Merkmalextraktion über die 10-GHz-Schwelle hinaus beschleunigt — ein Meilenstein mit Folgen für den Hochfrequenzhandel, die medizinische Bildgebung und Echtzeit-KI-Anwendungen. Indem eine zentrale Rechenstufe von Elektrizität auf Licht verlagert wird, berichten die Entwickler von deutlich geringerer Latenz und einem Weg zu leichteren, schnelleren hybriden KI-Systemen.

Warum Licht? Der Flaschenhals in moderner KI-Rechenleistung

Moderne KI- und datengetriebene Systeme — von Operationsrobotern bis zu automatisierten Handelsalgorithmen — müssen riesige, kontinuierliche Datenströme in Millisekunden oder weniger auswerten und relevante Merkmale extrahieren. Klassische elektronische Prozessoren stoßen dabei zunehmend an physikalische und thermische Grenzen. Höhere Taktraten und dichter integrierte Transistoren skalieren nicht mehr so wie früher: Elektronische Interconnects und Speicherzugriffe erzeugen Latenz und Energieaufwand, die für ultraschnelle Anwendungen prohibitiv werden.

Optische Rechentechnik ersetzt Elektronen durch Photonen, um bestimmte mathematische Operationen mit Lichtgeschwindigkeit auszuführen. Photonische Systeme bieten nahezu sofortige Datenübertragung, inhärente Parallelität (mehrere Wellenlängen und räumliche Kanäle gleichzeitig) und potenziell deutlich geringeren Energieverbrauch pro Operation. Ein vielversprechender Ansatz nutzt diffraktionsbasierte optische Operatoren: dünne optische Elemente, die einfallende Lichtfelder in gewünschte Ausgabemuster transformieren und damit linearalgebraische Operationen wie Matrix-Vektor-Multiplikationen in einem Durchgang realisieren können.

OFE2 kann flexible Ressourcenallokation unterstützen, um Multitasking-Anforderungen in Szenenerkennung, medizinischer Assistenz und digitaler Finanzwelt zu erfüllen.

Wie OFE2 Kohärenz- und Stabilitätsprobleme überwindet

Das neue Gerät, OFE2 (Optical Feature Extraction Engine 2), adressiert eine zentrale Einschränkung kohärenter optischer Rechensysteme: die Aufrechterhaltung stabiler Phasenbeziehungen zwischen parallelen optischen Kanälen bei sehr hohen Geschwindigkeiten. Viele photonische Systeme nutzen faserbasierte Splitter und Verzögerungsleitungen, um mehrere Datenkanäle zu erzeugen. Fasern führen jedoch Phasenrauschen und temperaturempfindliche Störungen ein, die die Betriebsfrequenz begrenzen.

Um dieses Problem zu lösen, entwickelte das Tsinghua-Team ein integriertes On-Chip-Datenvorbereitungsmodul mit einstellbaren Leistungsverteilern (tunable power splitters) und präzise kontrollierten Verzögerungsleitungen. Dieses Modul sampelt einen eintreffenden seriellen Datenstrom und deserialisiert ihn in mehrere stabile parallele optische Zweige. Ein anpassbares, integriertes Phasenarray erlaubt es anschließend, die Interferenz dieser Zweige am diffraktiven Operator neu zu konfigurieren. Auf diese Weise kann der Chip optische Energie gezielt auf ausgewählte Ausgänge lenken und spezifische Merkmalsdetektoren realisieren.

Die On-Chip-Datenvorbereitung ist ein entscheidender Schritt, weil sie die Kopplung zwischen seriellen elektronischen Datenströmen und der parallelen photonischen Verarbeitungsstufe herstellt. Durch präzise Leistungsaufteilung und verzögerungsbasierte Deserialisierung lassen sich stabile Phasenverhältnisse erzeugen, die für kohärente Interferenzvorgänge notwendig sind. Diese Stabilität reduziert Fehler durch thermische Drift oder Vibrationsstörungen und erhöht die Wiederholbarkeit der optischen Rechenoperationen.

Wesentlich ist auch die Fähigkeit zur Laufzeit-Neukonfiguration: Das integrierte Phasenarray gestattet adaptives Umsteuern und damit die Umsetzung verschiedener, während des Betriebs änderbarer Gewichtungsmuster. Diese Flexibilität macht OFE2 zu einem vielseitigen Front-End-Beschleuniger für unterschiedliche Feature-Extraktionsaufgaben.

Diffraktion als Rechenoperation: Matrixoperationen in einem Strahl

Richtig konfiguriert verhält sich der diffraktive Operator wie eine programmierte Matrix. Eintreffende Wellen — jede trägt einen Datenanteil — interferieren beim Durchgang durch das diffraktive Element, und das entstehende Intensitätsmuster erzeugt fokussierte Helligkeitsspots, deren Position und Intensität das Ergebnis einer Matrix-Vektor-Multiplikation kodieren. Indem man nachverfolgt, wie sich die Ausgangsleistung mit der Zeit oder bei Variation von Eingangssignalen verschiebt, extrahiert OFE2 Merkmale wie Bildkanten oder zeitliche Muster in Marktpreisdaten.

Auf physikalischer Ebene beruht dieser Ansatz auf dem Prinzip der linearen Systemantwort: Die diffraktive Fläche implementiert räumlich verteilte Phasen- und Amplitudenkodierungen, die das durchlaufende Feld linear transformieren. Das erlaubt, ohne aktive Nichtlinearitäten sehr hohe Geschwindigkeiten zu erreichen, da die Lichtausbreitung selbst die gewünschte lineare Operation übernimmt.

Für die praktische Umsetzung sind mehrere Parameter kritisch: die räumliche Auflösung und Feinabstufung der diffraktiven Struktur, der Dynamikbereich der detektierten Intensitäten, sowie die Güte der Phasenkontrolle in den vorgelagerten Kanälen. Ingenieurtechnisch bedeutet das ein Zusammenspiel aus Lithographiegenauigkeit bei der Fertigung, stabiler Temperaturführung und empfindlichen, schnellen Fotodetektoren nach der diffraktiven Stufe.

Leistung: 12,5 GHz und sub-250 ps Latenz

OFE2 arbeitet mit einer effektiven Rate von 12,5 GHz. Das Team berichtet, dass eine einzelne Matrix-Vektor-Multiplikation in unter 250,5 Pikosekunden abgeschlossen ist, womit diese Implementierung zu den schnellsten integrierten Demonstratoren optischer Rechentechnik zählt. Diese Sub-Nanosekunden-Latenz ist entscheidend, wenn jede Mikrosekunde zählt — etwa bei algorithmischen Handelsstrategien, wo kleine Verzögerungen über Profitabilität entscheiden können.

Der optische Vorverarbeitungsabschnitt reduziert maßgeblich die Belastung nachgeschalteter elektronischer neuronaler Netze. Bei Bildaufgaben erzeugte OFE2 komplementäre 'Relief- und Gravur'-Feature-Maps, die die Klassifikationsgenauigkeit verbesserten und die pixelgenaue Leistung in der semantischen Segmentierung (z. B. Organerkennung in CT-Scans) erhöhten, während gleichzeitig weniger elektronische Parameter als in einer rein elektronischen Pipeline erforderlich waren.

Neben der reinen Geschwindigkeit ist der Energieverbrauch pro Operation ein entscheidendes Kriterium. Da die Kernberechnungen in passiven optischen Komponenten stattfinden, kann der Energiebedarf pro Rechenoperation deutlich unter dem konventioneller elektronischer Vorverarbeitungsstufen liegen. Das bietet einen praktikablen Weg zu hybriden Architekturen, bei denen die Photonik die latenzkritischen, rechenintensiven Front-End-Aufgaben übernimmt und Elektronik für die höhergestuften Entscheidungsprozesse zuständig ist.

Technisch relevant sind dabei auch die Bandbreitenbegrenzungen durch Detektoren und die Umsetzungsverluste bei der opto-elektrischen Umwandlung. Die Gesamtsystem-Latenz hängt nicht nur von der diffraktiven Operation ab, sondern auch von der Geschwindigkeit der On-Chip-Phasenmodulation, der Detektorbandbreite und der Effizienz der nachfolgenden Verarbeitungsschritte.

Praxisprüfungen: Bilder und Marktsignale

Die Forscher validierten OFE2 an visuellen und finanziellen Aufgaben. In Bildexperimenten hob der diffraktive Motor zuverlässig Kanten und Texturmerkmale hervor, wodurch nachfolgende neuronale Netze bei Klassifikation und Segmentierung genauer und effizienter wurden. Für eine digitale Handelsaufgabe wurden Zeitreihen-Preissignale in OFE2 eingespeist und nach Training auf Handelsaktionen abgebildet; die optischen Ausgänge ließen sich mittels einfacher Schwellenwertbildung direkt in Kauf-/Verkaufsentscheidungen überführen und so eine handelsbezogene Schleife mit photonengetriebener Geschwindigkeit realisieren.

Die Validierung umfasste mehrere Testsets und Performance-Kennzahlen: Genauigkeit und F1-Score für Bildklassifikation, Pixelgenauigkeit bei Segmentierung sowie Sharpe-Ratio-Äquivalente und Ausführungslatenz für Handelsstrategien. Besonders in Szenarien mit hoher Ein- und Ausgangsdatenrate zeigte sich der Vorteil der optischen Vorverarbeitung durch reduzierte Systemlatenz und geringere Rechenlast auf elektronischer Seite.

Ein konkreter Vorteil in Finanz-Workloads ist die Möglichkeit, rote Signale in Hartschwellen für direkte Ausführung umzuwandeln, wodurch die Entscheidungslogik extrem vereinfacht wird und Hardware-nahe Trading-Loops realisierbar werden. Für die Medizin bietet die verbesserte Kanten- und Strukturdetektion bessere Vorverarbeitungsmasken, die wiederum die Robustheit und Interpretierbarkeit von KI-gestützten Diagnosesystemen stärken.

Verwandte Technologien und nächste Schritte

OFE2 reiht sich in ein wachsendes Ökosystem der integrierten Photonik ein: programmierbare photonische Schaltkreise, neuromorphe photonische Prozessoren und wellenlängenmultiplexe optische Beschleuniger. Wichtige Herausforderungen bleiben bestehen — die Integration zuverlässiger Lichtquellen (kompakte Laser), Verpackung für thermische Stabilität, reproduzierbare Fertigung und die Entwicklung von Entwurfstools, die maschinelle Lernmodelle auf physische diffraktive Layouts abbilden.

Insbesondere die Co-Optimierung von Hardware und Algorithmen ist entscheidend: Machine-Learning-Modelle müssen auf die Einschränkungen und Eigenschaften optischer Operatoren angepasst werden (z. B. begrenzter Dynamikbereich, linearer Arbeitsbereich), während die Hardwareentwickler leistungsfähige Schnittstellen und Steuerungs-APIs bereitstellen müssen. Werkzeuge zur automatischen Übersetzung von gängigen Netzwerkarchitekturen in diffraktive Gewichtsmuster sind daher ein zentrales Forschungsthema.

Das Tsinghua-Team veröffentlichte die Ergebnisse in Advanced Photonics Nexus und signalisierte Interesse an Kooperationen mit datenintensiven und latenzkritischen Anwendern. Der Weg von Laborprototypen zur industriellen Nutzung verlangt Co-Design mit Anwendungspartnern — Finanzunternehmen, Medizintechnikherstellern und Bildverarbeitungsfirmen —, um Schnittstellen, Steuerelektronik und Algorithmen produktionsreif zu machen.

Entwicklungsprioritäten für die nächsten Jahre umfassen:

- Integration kompakter, stabiler On-Chip-Laserquellen und effizienter Fotodetektoren;

- Fortschritte in der Packaging-Technologie zur Minimierung thermischer Drift und Vibrationseinflüsse;

- Skalierbare Fertigungsprozesse mit hoher Reproduzierbarkeit für diffraktive Elemente;

- Software-Toolchains zur automatischen Übersetzung von KI-Gewichten in optische Phase-/Amplitude-Profile;

- Standardisierte Schnittstellen für hybride photonen-elektronische Systeme, einschließlich Echtzeit-Steuerungslogik und Kalibrierungsroutinen.

Darüber hinaus muss die Standardisierung im Bereich der optischen Interoperabilität vorangetrieben werden, um Zulieferketten und Ökosysteme zu schaffen, die industrielle Adoption ermöglichen.

Expert Insight

Dr. Maria Alvarez, eine photonische Systemingenieurin (fiktional), kommentiert: ‚Diese Arbeit zeigt einen praktischen Weg, photonische Rechentechnik in Anwendungen zu bringen, die sowohl hohe Geschwindigkeit als auch Konfigurierbarkeit verlangen. Die integrierte Datenvorbereitung auf dem Chip ist eine Art technischer Fortschritt, der die Lücke zwischen Konzept-Optik und nützlichen, einsetzbaren Beschleunigern schließt. Wir sind noch nicht so weit, GPUs vollständig zu ersetzen, aber hybride photonisch-elektronische Stacks könnten die Architektur latenzkritischer KI-Systeme grundlegend verändern.‘

Ausblickend könnte die Kombination von OFE2-ähnlichen diffraktiven Operatoren mit kompakten Lasern und On-Chip-Detektoren ultra-schnelle Sensoren und Edge-Processor für Robotik, autonome Fahrzeuge und Finanzanwendungen ermöglichen. Wenn die photonische Fertigung reift und Algorithmen an optische Randbedingungen angepasst werden, sind mehr hybride Systeme zu erwarten, die Licht genau dort einsetzen, wo es am meisten zählt: an der Dateneingangsgrenze.

Zusammenfassend bietet OFE2 einen Weg, Latenz zu verringern, Energie pro Operation zu senken und die Performance in Anwendungen mit extremen Echtzeit-Anforderungen zu steigern. Die praktische Anwendung hängt von Fortschritten in der Integration, Verpackung und im Software-Ökosystem ab. Institutionen, die frühzeitig in diese Technologie investieren, können Wettbewerbsvorteile in Bereichen wie Hochfrequenzhandel, medizinische Bildgebung und eingebettete Echtzeit-KI erlangen.

Wichtige Schlüsselbegriffe in diesem Kontext sind photonische Rechentechnik, optische Verarbeitung, Merkmalextraktion, integrierte Photonik, diffraktive Operatoren, On-Chip-Phasenarray, hybride KI-Architektur und Latenzoptimierung. Ein klares Verständnis dieser Konzepte und ihrer Wechselwirkungen erleichtert die Bewertung, wann und wie optische Beschleuniger sinnvoll in bestehende Systeme eingebunden werden können.

Praktische Integrationsschritte für Anwender könnten folgendermaßen aussehen:

- Identifikation latenzkritischer Vorverarbeitungsschritte im bestehenden Datenpfad;

- Evaluation, ob diese Schritte als lineare Operatoren (z. B. Kantenextraktion, Filterung, lineare Projektion) formuliert werden können;

- Co-Design-Workshops mit photonischen Anbietern zur Definition von Schnittstellen und Kalibrierprozessen;

- Prototypische Integration in Test-Workloads (Backtesting bei Handelssystemen, Validierung an annotierten medizinischen Datensätzen);

- Schrittweise Skalierung und Produktion nach validierter Leistungssteigerung und Robustheitsnachweis.

Die technologische Reife wird maßgeblich von der Verfügbarkeit robuster On-Chip-Lichtquellen, skalierbarer Fertigung und verlässlicher Packaging-Techniken abhängen. Gleichzeitig sind regulatorische und sicherheitsbezogene Betrachtungen, insbesondere in der Medizintechnik, nicht zu vernachlässigen: Die Einbindung optischer Vorverarbeitung in diagnostische Systeme erfordert nachvollziehbare Validierungs- und Kalibrierprozesse, um klinische Zulassungen zu ermöglichen.

Insgesamt stellt OFE2 einen bedeutenden Schritt Richtung praktikable photonische Beschleuniger dar. Durch die Kombination von hoher Bandbreite, niedriger Latenz und reduzierter elektrischer Belastung eröffnet die Technologie neue Architekturen für Echtzeit-Datenverarbeitung an der Schnittstelle zwischen Sensorik und KI.

Quelle: scitechdaily

Kommentar hinterlassen